Эти пессимистические взгляды авторов из Западной Европы и Северной Америки в большинстве своем отвергались советскими исследователями. Как и философы, советские естествоиспытатели выражали, за редким исключением, оптимистические взгляды на науку. Если кто-нибудь из них, говоря словами Оппенгеймера, «познает грех» в результате своих исследований, они держат его при себе. Действительно, некоторые советские ученые говорили, что основная разница между человеком и машиной заключается в том, что человек ставит собственные цели, в то время как машина стремится лишь к тем, которые в нее закладываются. Если общество поощряет позитивные цели, говорили советские авторы, то и машинам этого общества будут задаваться достойные функции. Эти писатели предполагали, что кибернетики на Западе не уверены в капиталистическом обществе, а поэтому они не уверены в том, какие роли будут призваны играть их компьютеры.

Что такое «информация»?

Кибернетические системы действуют на базе сбора, переработки и передачи информации. Развитие все более совершенных средств оценки измерения информации было одним из важных факторов, определяющих прогресс кибернетики. Однако, что интересно, никто не выдвинул достаточно удовлетворительного определения информации. Норберт Винер однажды заметил, возможно без особого намерения, что «информация — это не материя или энергия», это просто «информация»[654]. У.Р. Эшби также предостерегал против попыток рассматривать информацию как материальную или индивидуальную «вещь»: «Всякая попытка трактовать информацию как вещь, которая может содержаться в другой вещи, обычно ведет к трудным „проблемам“, которые никогда не должны были бы возникать»[655].

Диалектический материализм утверждает, что объективная реальность состоит из материи и энергии в различных формах. Если информация не есть материя или энергия, тогда что же это? В начале 60-х годов внимание советских философов переместилось, пусть относительно, с более широких вопросов природы кибернетики и жизни к более узким проблемам природы информации. Они выдвигали несколько причин этого переноса внимания. Во-первых, более ограниченный вопрос о природе информации можно рассматривать более строго, чем вопрос «Могут ли машины мыслить?». Во-вторых, исследования проблемы информации есть ключ ко многим более общим вопросам, поставленным ранее.

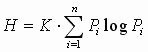

Проблема философской интерпретации понятия информации была подлинной и трудной. Если информацию можно измерять, считали некоторые советские ученые, тогда она должна обладать объективной реальностью. Еще в 1927 г. Р. В. Л. Хартли отмечал, что количество информации, заключенной в любом сообщении, тесно связано с количеством возможностей, сообщением исключающихся. Таким образом, фраза «яблоки красные» несет намного больше информации, чем фразы «фрукты красные» или «яблоки цветные», так как первая фраза исключает все фрукты, кроме яблок, и все цвета, кроме красного. Это исключение других возможностей повышает информационное содержание[656]. Позднее основной принцип, предложенный Хартли, был улучшен и разработан на математической основе. В 1949 г, в фундаментально важном труде «Математическая теория связи» Клод Шеннон и Уоррен Уивер представили формулу вычисления количества информации, в которой информация возрастала с уменьшением вероятности отдельного сообщения. В этом методе информация определяется как мера свободы чьего-либо (или какой-либо системы) выбора в выделении сообщения. Таким образом, в ситуации, когда количество возможных сообщений, из которых можно выбирать, большое, количество информации, производимое этой системой, тоже большое, Если быть более точными, количество информации определяется (в простых ситуациях) как логарифм доступных выборов. Формула Шеннона и Уивера 1949 г. имела следующий вид:

где Н — количество информации в системе с выбором сообщений, с вероятностями (Р1, Р2… Рn), К — константа, зависимая от единицы измерения[657]. Эта формула функционально эквивалентна формуле, разработанной М. Планком для термодинамической энтропии в начале века; S = k log W, где S равно энтропии системы, W — термодинамической вероятности состояния системы, k — константа Больцмана[658].

Некоторые ученые считали возможные применения этого совпадения огромными. Возможность какой-либо аналогии или даже структурного совпадения энтропии и информации вызвало оживленные обсуждения среди физиков, философов и инженеров многих стран. Уивер комментировал: «Встречая понятие энтропии в теории связи, человек имеет право волноваться, подозревая, что он обладает чем-то основополагающим и важным». Луи де Бройль считал вывод о глубокой аналогии между энтропией и информацией «самой важной и привлекательной из идей, выдвинутых кибернетикой»[659].

Если будет доказано, что связь между негоэнтропией и информацией — это больше, чем функциональное сходство или, более того, идентичность, то конструкция общей теории материи, согласно которой все сложные системы — неорганические и органические, включая человека, — могут быть математически описаны, становится, по меньшей мере, возможной. Диалектические материалисты начали более смело приветствовать такую возможность, так как она казалась им оправданием материалистического монизма. Попытка четко изложить три основных закона диалектики в терминах кибернетики была предпринята автором неопубликованной докторской диссертации в Московском университете[660]. Более ортодоксальное большинство, однако, было обеспокоено трудностями подгонки такой честолюбивой теории к принципам диалектического материализма.

Дополнительная проблема интерпретации теорий информации в терминах диалектического материализма была связана с предполагаемой «субъективной» природой количества информации. Сторонники субъективного подхода (Эшби и Л. Бриллюэн в том числе) указывали на то, что едва ли можно твердо говорить в абсолютных терминах о количестве информации в любом сообщении, так как отдельное сообщение будет нести намного больше информации для одного наблюдателя, чем для другого, в зависимости от исходного знания наблюдателя. Следуя этому подходу, некоторые западные авторы призывали присоединять качественные коэффициенты к вычислениям количества информации, основываясь на ценности информации, степени достоверности и значимости. Но если информация (разнообразие) должна количественно измеряться, настаивали советские философы, то она должна быть частью объективной реальности и не должна обусловливаться субъективными соображениями. Соответствующим было замечание А.Д. Урсула по этому поводу: «Прежде всего отметим, что для конечного объекта (системы) количество разнообразия, внутренне ему присущее, не зависит от наблюдателя и всегда ограничено…»[661]

Не только в Советском Союзе ученые были осторожными в отношении теории информации: любому энтузиасту, который пытался бы отождествить информацию и негоэнтропию, другой трезвомыслящий коллега адресовал бы предостерегающее замечание. Эшби, например, заметил: «Движение в этих областях напоминает движение в джунглях, полных ловушек. Наиболее знакомые с этим предметом обычно наиболее осторожны в разговорах о нем»[662]. И однако, несмотря на предупреждения, основным движением среди кибернетиков начала 60-х годов было более широкое признание концепции о наличии некоторой существенной связи между энтропией и информацией.